Après que Google DeepMind ait vaincu les humains dans tous les domaines, depuis Jouer Aller aux jeux de société de stratégie,

il prétend désormais être sur le point de battre les meilleurs élèves du monde pour résoudre des problèmes de mathématiques.

Le basé à Londres Apprentissage automatique L'entreprise a annoncé le 25 juillet que ses systèmes d'intelligence artificielle (IA) avaient résolu quatre des six problèmes posés aux étudiants de l'Olympiade internationale de mathématiques (OMI) 2024 à Bath, au Royaume-Uni. L'IA a fourni des preuves rigoureuses, étape par étape, évaluées par deux mathématiciens de haut niveau et a obtenu un score de 28/42, soit seulement un point du territoire de la médaille d'or.

"C'est évidemment une avancée très significative", déclare Joseph Myers, un mathématicien de Cambridge, au Royaume-Uni, qui, avec le médaillé Fields Tim Gowers, a examiné les solutions et aidé à sélectionner les problèmes initiaux pour l'OMI de cette année.

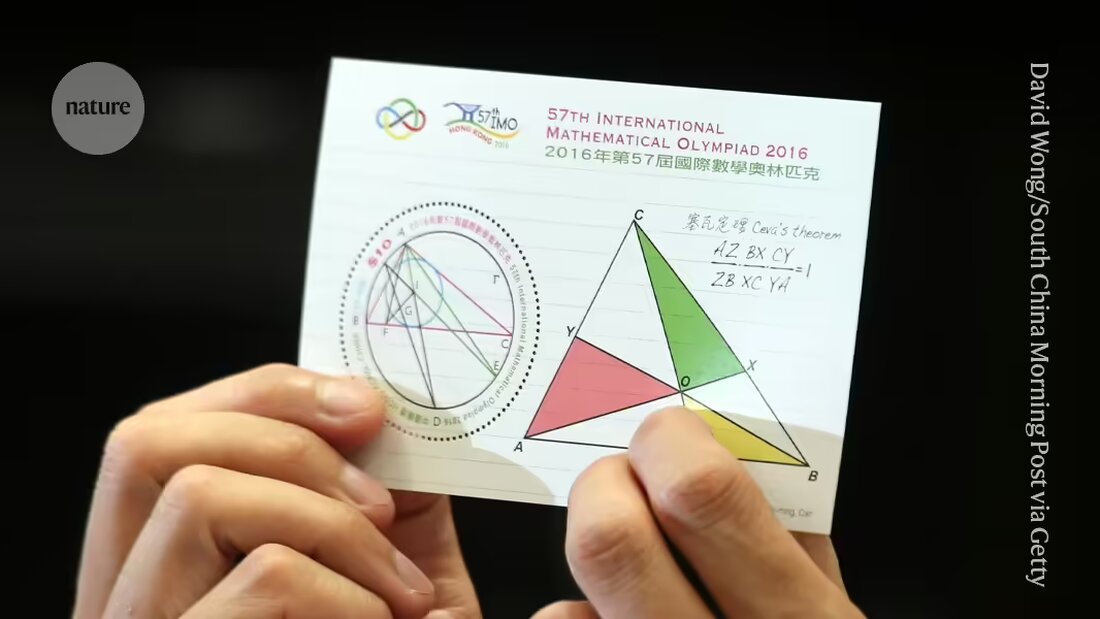

DeepMind et d’autres sociétés sont dans la course pour fournir aux machines des preuves qui comptent Résoudre des questions de recherche en mathématiques. Les problèmes présentés à l'OMI, le principal concours mondial pour les jeunes mathématiciens, sont devenus une référence pour progresser vers cet objectif et sont considérés comme un « grand défi » pour l'apprentissage automatique, a déclaré la société.

"C'est la première fois qu'un système d'IA atteint des performances de niveau médaille", a déclaré Pushmeet Kohli, vice-président de l'IA scientifique chez DeepMind, lors d'un point de presse. "Il s'agit d'une étape importante dans la constitution d'enquêteurs avancés en matière de preuves", a déclaré Kohli.

Extension

Il y a quelques mois à peine, en janvier, le système DeepMind Réalisations au niveau de la médaille AlphaGeometry réalisé en résolvant un type de problèmes de l’OMI, à savoir ceux de la géométrie euclidienne. La première IA à obtenir une médaille d'or à l'examen global – comprenant des questions d'algèbre, de combinatoire et de théorie des nombres, généralement considérées comme plus difficiles que la géométrie – sera éligible pour recevoir un prix de 5 millions de dollars, le Prix de l'Olympiade de mathématiques de l'IA (AIMO). (Le prix comporte des critères stricts tels que la divulgation du code source et le travail avec une puissance de calcul limitée, ce qui signifie que les efforts actuels de DeepMind ne seraient pas admissibles.)

Dans leur dernière tentative, les chercheurs ont utilisé AlphaGeometry2 pour résoudre le problème de géométrie en moins de 20 secondes ; l'IA est une version améliorée et plus rapide de leur système d'enregistrement, explique Thang Luong, spécialiste en informatique de DeepMind.

Pour les autres types de questions, l’équipe a développé un tout nouveau système appelé AlphaProof. AlphaProof a résolu deux problèmes d'algèbre dans le cadre du concours et un de théorie des nombres, ce qui a duré trois jours. (Les participants à l'OMI proprement dite disposent de deux sessions de 4,5 heures chacune.) Il n'a pas été en mesure de résoudre les deux problèmes de combinatoire, un autre domaine des mathématiques.

Les chercheurs ont obtenu des résultats mitigés lorsqu’ils ont répondu à des questions mathématiques à l’aide de modèles linguistiques – le type de systèmes qui alimentent les chatbots comme ChatGPT. Parfois les modèles donnent la bonne réponse mais ne peuvent pas expliquer leur raisonnement de manière rationnelle, et parfois ils racontent des bêtises.

La semaine dernière, une équipe de chercheurs des éditeurs de logiciels Numina et HuggingFace a utilisé un modèle de langage pour remporter un « prix de progrès » AMIO intermédiaire basé sur des versions simplifiées des problèmes de l'OMI. Les entreprises ont rendu l’intégralité de leurs systèmes open source et les ont mis à la disposition d’autres chercheurs qui peuvent les télécharger. Mais les gagnants ont ditNature, que les modèles linguistiques à eux seuls ne suffiraient probablement pas à résoudre des problèmes plus difficiles.

Seule la classe

AlphaProof combine un modèle de langage avec une technologie d'apprentissage par renforcement qui utilise le moteur « AlphaZero » que la société a utilisé avec succès pour des jeux d'attaque tels que Go et certains problèmes mathématiques spécifiques utilisé. Dans l’apprentissage par renforcement, un réseau neuronal apprend par essais et erreurs. Cela fonctionne bien lorsque ses réponses peuvent être évaluées à l’aide d’une norme objective. À cette fin, AlphaProof a été formé à lire et à écrire des preuves dans un langage formel appelé Lean, utilisé dans le progiciel « Proof Assistant » du même nom, populaire auprès des mathématiciens. Pour ce faire, AlphaProof a testé si ses sorties étaient correctes en les exécutant dans le package Lean, ce qui a permis de compléter certaines étapes du code.

La formation d'un modèle de langage nécessite d'énormes quantités de données, mais peu de preuves mathématiques étaient disponibles dans le Lean. Pour surmonter ce problème, l'équipe a développé un réseau supplémentaire qui a tenté de traduire en Lean un enregistrement existant d'un million de problèmes écrits en langage naturel mais sans solutions écrites par l'homme, explique Thomas Hubert, chercheur en apprentissage automatique chez DeepMind qui a codirigé le développement d'AlphaProof. « Notre approche était la suivante : pouvons-nous apprendre à prouver même si nous ne nous sommes pas initialement formés sur des preuves écrites par des humains ? (La société a adopté une approche similaire à Go, où son IA a appris à jouer en jouant contre elle-même plutôt qu'en suivant la façon dont les humains le font.)

Clés magiques

La plupart des traductions Lean n'avaient pas de sens, mais elles étaient suffisamment bonnes pour amener AlphaProof au point où il pouvait commencer ses cycles d'apprentissage par renforcement. Les résultats ont été bien meilleurs que prévu, a déclaré Gowers lors du point de presse. "De nombreux problèmes à l'OMI ont cette propriété de clé magique. Le problème semble difficile au début jusqu'à ce que vous trouviez une clé magique qui l'ouvre", a déclaré Gowers, qui travaille au Collège de France à Paris.

Dans certains cas, AlphaProof semblait être en mesure de fournir cette étape supplémentaire de créativité en proposant une étape correcte parmi une solution possible infiniment grande. Mais une analyse plus approfondie est nécessaire pour déterminer si les réponses étaient moins surprenantes qu’elles ne le paraissaient, a ajouté Gowers. Un discours similaire a émergé après celui surprenant "Train 37", le bot DeepMinds AlphaGo à son célèbre victoire de 2016 sur le meilleur joueur de Go humain au monde réalisé – un tournant pour l’IA.

Reste à savoir si les techniques peuvent être perfectionnées pour travailler au niveau de la recherche en mathématiques, a déclaré Myers lors de la conférence de presse. « Peut-il s'étendre à d'autres types de mathématiques sur lesquelles des millions de problèmes ne sont peut-être pas entraînés ? »

"Nous sommes au point où ils peuvent prouver non seulement des problèmes de recherche ouverts, mais aussi des problèmes très difficiles pour les meilleurs jeunes mathématiciens du monde", a déclaré David Silver, spécialiste en informatique de DeepMind, qui était le chercheur principal développant AlphaGo au milieu des années 2010.

Suche

Suche

Mein Konto

Mein Konto