Dopo che Google DeepMind ha sconfitto gli umani in tutto, da Gioca Vai ai giochi da tavolo di strategia,

ora afferma di essere sul punto di battere i migliori studenti del mondo nella risoluzione dei problemi di matematica.

Quello con sede a Londra Apprendimento automatico La società ha annunciato il 25 luglio che i suoi sistemi di intelligenza artificiale (AI) hanno risolto quattro dei sei problemi assegnati agli studenti alle Olimpiadi internazionali della matematica (IMO) del 2024 a Bath, nel Regno Unito. L'intelligenza artificiale ha fornito dimostrazioni rigorose e passo passo, valutate da due eminenti matematici e ha ottenuto un punteggio di 28/42, solo un punto fuori dal territorio della medaglia d'oro.

"Si tratta ovviamente di un progresso molto significativo", afferma Joseph Myers, un matematico di Cambridge, nel Regno Unito, che, insieme alla medaglia Fields Tim Gowers, ha esaminato le soluzioni e ha contribuito a selezionare i problemi originali per l'IMO di quest'anno.

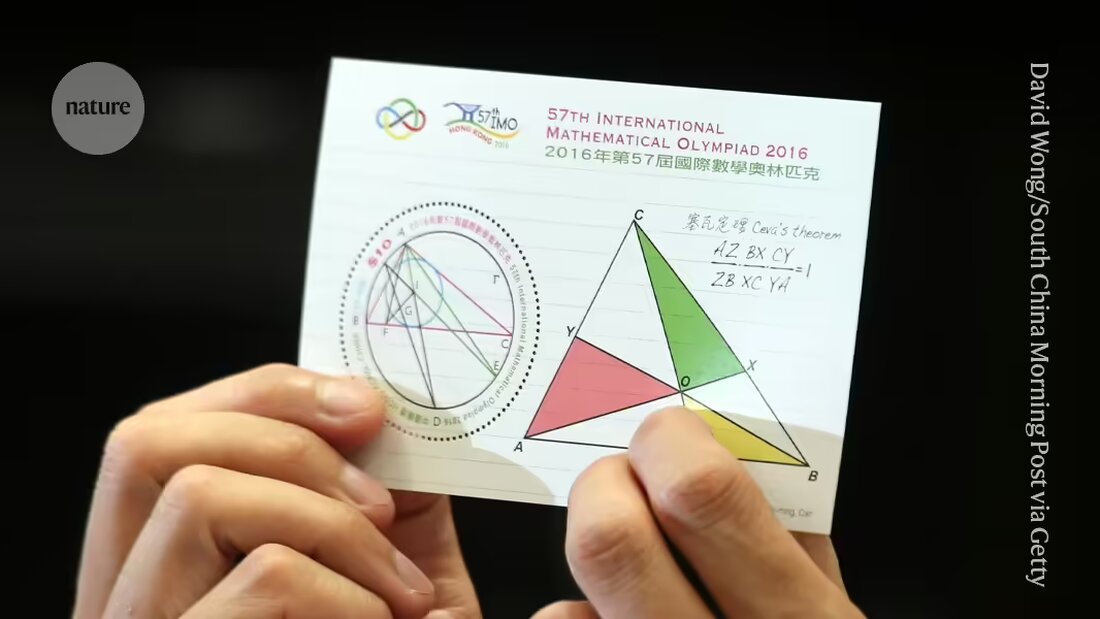

DeepMind e altre società sono in corsa per fornire alle macchine prove che contano Risolvere domande di ricerca in matematica. I problemi presentati all'IMO, la principale competizione mondiale per giovani matematici, sono diventati un punto di riferimento per i progressi verso tale obiettivo e sono considerati una "grande sfida" per l'apprendimento automatico, ha affermato l'azienda.

"Questa è la prima volta che un sistema di intelligenza artificiale raggiunge prestazioni a livello di medaglia", ha affermato Pushmeet Kohli, vicepresidente dell'intelligenza artificiale per la scienza presso DeepMind, in una conferenza stampa. "Questa è una pietra miliare importante nella costruzione di investigatori di prove avanzate", ha detto Kohli.

Estensione

Solo pochi mesi fa, a gennaio, è nato il sistema DeepMind Risultati a livello di medaglia AlphaGeometry raggiunto nella risoluzione di un tipo di problemi IMO, vale a dire quelli nella geometria euclidea. La prima IA che otterrà il livello della medaglia d’oro nel test complessivo – comprese domande di algebra, calcolo combinatorio e teoria dei numeri, generalmente considerate più impegnative della geometria – avrà diritto a ricevere un premio di 5 milioni di dollari, l’AI Mathematics Olympiad Prize (AIMO). (Il premio prevede criteri rigorosi come la divulgazione del codice sorgente e il lavoro con una potenza di calcolo limitata, il che significa che gli attuali sforzi di DeepMind non sarebbero idonei.)

Nel loro ultimo tentativo, i ricercatori hanno utilizzato AlphaGeometry2 per risolvere il problema della geometria in meno di 20 secondi; l'intelligenza artificiale è una versione migliorata e più veloce del loro sistema di registrazione, afferma lo specialista di computer DeepMind Thang Luong.

Per gli altri tipi di domande, il team ha sviluppato un sistema completamente nuovo chiamato AlphaProof. AlphaProof ha risolto due problemi di algebra del concorso e uno di teoria dei numeri, che hanno richiesto tre giorni. (I partecipanti all’IMO vero e proprio hanno due sessioni di 4,5 ore ciascuna.) Non è stato in grado di risolvere i due problemi di calcolo combinatorio, un’altra area della matematica.

I ricercatori hanno ottenuto risultati contrastanti rispondendo a domande matematiche utilizzando modelli linguistici, il tipo di sistemi che alimentano chatbot come ChatGPT. A volte i modelli danno la risposta giusta ma non riescono a spiegare razionalmente il loro ragionamento, e a volte dicono sciocchezze.

Proprio la scorsa settimana, un team di ricercatori delle società di software Numina e HuggingFace ha utilizzato un modello linguistico per vincere un "premio per il progresso" intermedio dell'AMIO basato su versioni semplificate dei problemi IMO. Le aziende hanno reso i loro interi sistemi open source e li hanno resi disponibili per il download ad altri ricercatori. Ma i vincitori hanno dettoNatura, che i modelli linguistici da soli probabilmente non sarebbero sufficienti a risolvere problemi più difficili.

Solo classe

AlphaProof combina un modello linguistico con una tecnologia di apprendimento per rinforzo che utilizza il motore "AlphaZero" che l'azienda ha utilizzato con successo per giochi di attacco come Go e alcuni problemi matematici specifici usato. Nell'apprendimento per rinforzo, una rete neurale impara attraverso tentativi ed errori. Funziona bene quando le sue risposte possono essere valutate utilizzando uno standard oggettivo. A tal fine, AlphaProof è stato addestrato a leggere e scrivere dimostrazioni in un linguaggio formale chiamato Lean, utilizzato nell'omonimo pacchetto software "Proof Assistant" popolare tra i matematici. Per fare ciò, AlphaProof ha testato se i suoi risultati erano corretti eseguendoli nel pacchetto Lean, che ha aiutato a compilare alcuni passaggi del codice.

L’addestramento di un modello linguistico richiede enormi quantità di dati, ma in Lean erano disponibili poche prove matematiche. Per superare questo problema, il team ha sviluppato una rete aggiuntiva che ha tentato di tradurre in Lean un record esistente di un milione di problemi scritti in linguaggio naturale ma senza soluzioni scritte da esseri umani, afferma Thomas Hubert, un ricercatore di machine learning di DeepMind che ha co-guidato lo sviluppo di AlphaProof. "Il nostro approccio era: possiamo imparare a dimostrare anche se inizialmente non ci siamo formati su dimostrazioni scritte da esseri umani?" (L'azienda ha adottato un approccio simile a Go, dove la sua intelligenza artificiale ha imparato a giocare giocando contro se stessa piuttosto che dal modo in cui lo fanno gli umani.)

Chiavi magiche

Molte delle traduzioni Lean non avevano senso, ma ce n'erano abbastanza per portare AlphaProof al punto in cui poteva iniziare i suoi cicli di apprendimento di rinforzo. I risultati sono stati molto migliori del previsto, ha detto Gowers durante la conferenza stampa. "Molti problemi dell'IMO hanno questa proprietà della chiave magica. All'inizio il problema sembra difficile finché non trovi una chiave magica che lo apra", ha detto Gowers, che lavora al Collège de France a Parigi.

In alcuni casi, AlphaProof sembrava essere in grado di fornire quel passo in più di creatività fornendo un passo corretto da una possibile soluzione infinitamente grande. Ma sono necessarie ulteriori analisi per determinare se le risposte siano state meno sorprendenti di quanto sembrassero, ha aggiunto Gowers. Un discorso simile è emerso dopo quello sorprendente "Treno 37", il bot DeepMinds AlphaGo al suo famosa vittoria del 2016 sul miglior giocatore di Go umano del mondo made – un punto di svolta per l’intelligenza artificiale.

Resta da vedere se le tecniche potranno essere perfezionate per funzionare a livello di ricerca in matematica, ha detto Myers durante la conferenza stampa. "Può espandersi ad altri tipi di matematica su cui potrebbero non essere affrontati milioni di problemi?"

"Siamo al punto in cui possono dimostrare non solo problemi di ricerca aperti, ma anche problemi che sono molto impegnativi per i migliori giovani matematici del mondo", ha affermato David Silver, specialista di computer di DeepMind, che è stato il ricercatore principale che ha sviluppato AlphaGo a metà degli anni 2010.

Suche

Suche

Mein Konto

Mein Konto