Nadat Google DeepMind mensen in alles had verslagen, van Speel Ga naar strategische bordspellen,

het beweert nu op het punt te staan de beste studenten ter wereld te verslaan bij het oplossen van wiskundeproblemen.

Het in Londen gevestigde Machinaal leren Het bedrijf maakte op 25 juli bekend dat zijn kunstmatige intelligentie (AI)-systemen vier van de zes problemen hebben opgelost waarmee studenten op de Internationale Wiskunde Olympiade (IMO) 2024 in Bath, Verenigd Koninkrijk, werden geconfronteerd. De AI leverde rigoureuze, stapsgewijze bewijzen, geëvalueerd door twee topwiskundigen, en behaalde een score van 28/42 - slechts één punt buiten het gouden medaillegebied.

"Het is duidelijk een zeer belangrijke vooruitgang", zegt Joseph Myers, een wiskundige uit Cambridge, VK, die samen met Fields-medaillewinnaar Tim Gowers de oplossingen beoordeelde en hielp bij het selecteren van de oorspronkelijke problemen voor de IMO van dit jaar.

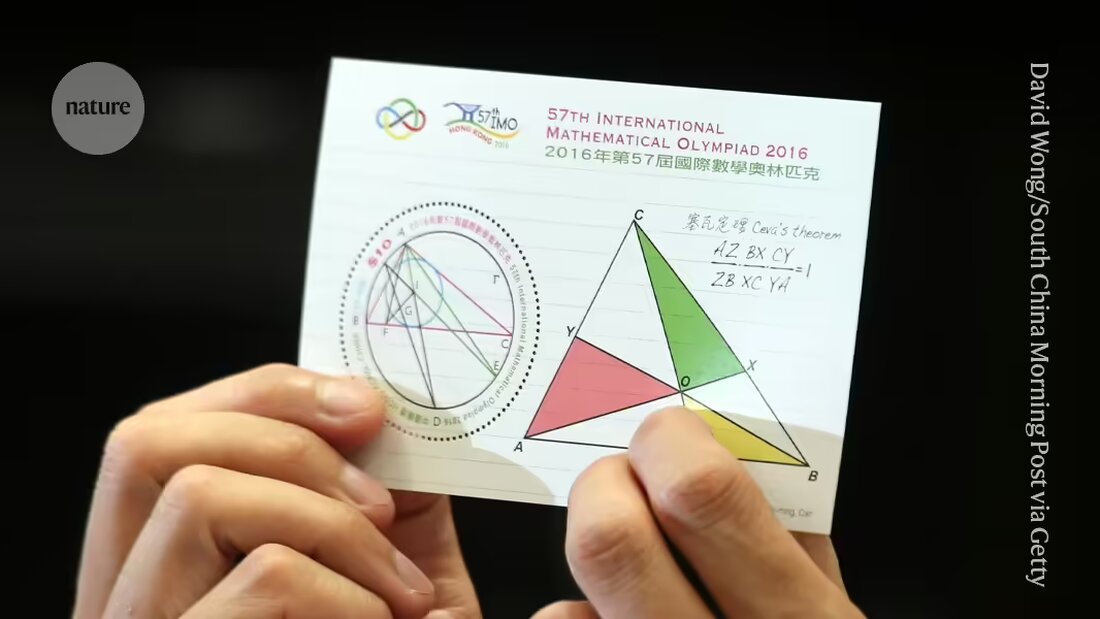

DeepMind en andere bedrijven zijn in de race om machines uiteindelijk te voorzien van bewijsmateriaal dat er toe doet Onderzoeksvragen in de wiskunde oplossen. De problemen die worden gepresenteerd op de IMO, 's werelds grootste competitie voor jonge wiskundigen, zijn een maatstaf geworden voor de vooruitgang in de richting van dat doel en worden beschouwd als een "grote uitdaging" voor machinaal leren, aldus het bedrijf.

“Dit is de eerste keer dat een AI-systeem prestaties op medailleniveau bereikt”, zei Pushmeet Kohli, vice-president van AI in de wetenschap bij DeepMind, tijdens een persconferentie. “Dit is een belangrijke mijlpaal in het opbouwen van geavanceerde bewijsonderzoekers”, zei Kohli.

Verlenging

Nog maar een paar maanden geleden, in januari, het DeepMind-systeem Prestaties op AlphaGeometry-medailleniveau bereikt bij het oplossen van één type IMO-problemen, namelijk die in de Euclidische meetkunde. De eerste AI die op het niveau van de gouden medaille presteert op de algemene test – inclusief vragen in algebra, combinatoriek en getaltheorie, die over het algemeen als uitdagender worden beschouwd dan meetkunde – komt in aanmerking voor een prijs van $ 5 miljoen, de AI Wiskunde Olympiade Prijs (AIMO). (De prijs kent strikte criteria, zoals het vrijgeven van de broncode en het werken met beperkte rekenkracht, wat betekent dat de huidige inspanningen van DeepMind niet in aanmerking komen.)

In hun laatste poging gebruikten de onderzoekers AlphaGeometry2 om het geometrieprobleem in minder dan 20 seconden op te lossen; de AI is een verbeterde en snellere versie van hun recordsysteem, zegt computerspecialist Thang Luong van DeepMind.

Voor de overige soorten vragen ontwikkelde het team een compleet nieuw systeem: AlphaProof. AlphaProof loste twee algebraproblemen op in de competitie en één in de getaltheorie, wat drie dagen duurde. (Deelnemers aan de eigenlijke IMO hebben twee sessies van elk 4,5 uur.) Het lukte niet om de twee problemen op te lossen in de combinatoriek, een ander gebied van de wiskunde.

Onderzoekers hebben gemengde resultaten behaald bij het beantwoorden van wiskundige vragen met behulp van taalmodellen – het soort systemen dat chatbots als ChatGPT aanstuurt. Soms geven de modellen het juiste antwoord, maar kunnen ze hun redenering niet rationeel verklaren, en soms ze spuien onzin.

Vorige week nog gebruikte een team van onderzoekers van softwarebedrijven Numina en HuggingFace een taalmodel om een tussentijdse AMIO 'vooruitgangsprijs' te winnen, gebaseerd op vereenvoudigde versies van IMO-problemen. De bedrijven hebben hun volledige systemen open source gemaakt en beschikbaar gesteld voor download door andere onderzoekers. Maar de winnaars zeidenNatuur, dat taalmodellen alleen waarschijnlijk niet voldoende zouden zijn om moeilijkere problemen op te lossen.

Alleen maar klasse

AlphaProof combineert een taalmodel met versterkende leertechnologie die gebruik maakt van de ‘AlphaZero’-engine die het bedrijf met succes heeft gebruikt voor aanvalsspellen zoals Go en sommige specifieke wiskundige problemen gebruikt. Bij versterkend leren leert een neuraal netwerk door middel van vallen en opstaan. Dit werkt goed als zijn antwoorden kunnen worden beoordeeld aan de hand van een objectieve maatstaf. Daartoe werd AlphaProof getraind in het lezen en schrijven van bewijzen in een formele taal genaamd Lean, die wordt gebruikt in het gelijknamige softwarepakket 'Proof Assistant' dat populair is bij wiskundigen. Om dit te doen testte AlphaProof of de uitvoer correct was door ze in het Lean-pakket uit te voeren, wat hielp bij het invullen van enkele stappen in de code.

Het trainen van een taalmodel vereist enorme hoeveelheden gegevens, maar er was in Lean weinig wiskundig bewijs beschikbaar. Om dit probleem te overwinnen ontwikkelde het team een aanvullend netwerk dat probeerde een bestaand record van een miljoen problemen geschreven in natuurlijke taal, maar zonder door mensen geschreven oplossingen, te vertalen naar Lean, zegt Thomas Hubert, een DeepMind machine learning-onderzoeker die mede leiding gaf aan de ontwikkeling van AlphaProof. “Onze aanpak was: kunnen we leren bewijzen, ook al hebben we oorspronkelijk niet getraind op door mensen geschreven bewijzen?” (Het bedrijf hanteerde een soortgelijke benadering als Go, waarbij de AI het spel leerde spelen door tegen zichzelf te spelen in plaats van door de manier waarop mensen het doen.)

Magische sleutels

Veel van de Lean-vertalingen waren niet logisch, maar genoeg waren goed genoeg om AlphaProof op het punt te krijgen waarop het zijn versterkende leercycli kon beginnen. De resultaten waren veel beter dan verwacht, zei Gowers op de persconferentie. "Veel problemen bij de IMO hebben deze magische sleutel-eigenschap. Het probleem ziet er in eerste instantie moeilijk uit totdat je een magische sleutel vindt die het opent", zegt Gowers, die aan het Collège de France in Parijs werkt.

In sommige gevallen leek AlphaProof die extra stap creativiteit te kunnen bieden door één juiste stap te zetten vanuit een oneindig groot mogelijke oplossing. Maar verdere analyse is nodig om te bepalen of de antwoorden minder verrassend waren dan ze leken, voegde Gowers eraan toe. Een soortgelijk discours ontstond na de verrassende 'Trein 37', de DeepMinds AlphaGo-bot bij hem beroemde overwinning uit 2016 op 's werelds beste menselijke Go-speler gemaakt – een keerpunt voor AI.

Of de technieken kunnen worden geperfectioneerd om op onderzoeksniveau in de wiskunde te werken, valt nog te bezien, zei Myers op de persconferentie. “Kan het zich uitbreiden naar andere soorten wiskunde waarvoor misschien niet miljoenen problemen zijn getraind?”

"We staan op het punt waarop ze niet alleen open onderzoeksproblemen kunnen bewijzen, maar ook problemen die een grote uitdaging vormen voor de allerbeste jonge wiskundigen ter wereld", zegt DeepMind-computerspecialist David Silver, die halverwege de jaren 2010 de hoofdonderzoeker was bij de ontwikkeling van AlphaGo.

Suche

Suche

Mein Konto

Mein Konto