Forskere bruger teknikker fra astronomi til at skabe computergenererede "Deepfake" billeder at genkende - som ved første øjekast kan se identisk ud med rigtige billeder.

Ved at analysere billeder af ansigter, der typisk bruges til at studere fjerne galakser, kan astronomer måle, hvordan en persons øjne reflekterer lys, hvilket kan indikere tegn på billedmanipulation.

"Det er ikke et vidundermiddel, da vi har falske positive og falske negative," siger Kevin Pimbblet, direktør for Center for Data Science, Artificial Intelligence and Modeling ved University of Hull, UK. Han præsenterede forskningen ved Royal Astronomical Society's National Astronomy Meeting den 15. juli "Men denne forskning tilbyder en potentiel metode, et vigtigt skridt fremad, til potentielt at tilføje til de tests, der kan bruges til at finde ud af, om et billede er ægte eller falsk."

Udtrykte billeder

Fremskridt inden for kunstig intelligens (AI) gør det stadig sværere at kende forskel på rigtige billeder, videoer og lyd dem, der er skabt af algoritmer, at genkende. Deepfakes erstatter træk ved én person eller miljø med andre og kan få det til at se ud, som om individer har sagt eller gjort ting, de ikke gjorde. Myndighederne advarer om, at denne teknologi militariserer og bidrager til spredningen af misinformation, for eksempel ved valg, kan bruges.

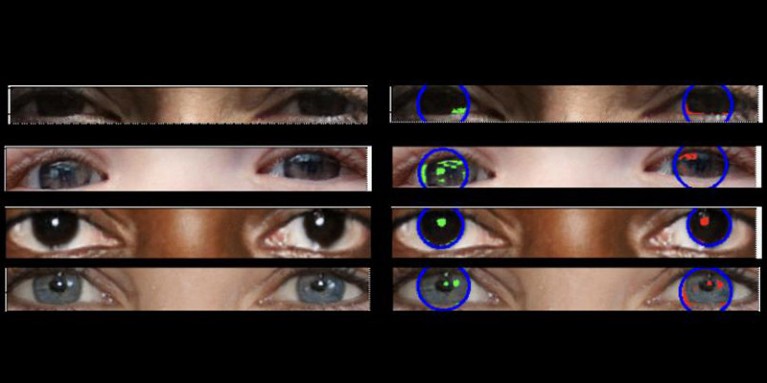

Rigtige fotos bør have "konsistent fysik," forklarer Pimbblet, "så de refleksioner, du ser i venstre øjeæble, bør være meget ens, men ikke nødvendigvis identiske, med refleksionerne i højre øjeæble." Forskellene er subtile, så forskerne henvendte sig til teknikker udviklet til at analysere lys i astronomiske billeder.

Værket, som endnu ikke er offentliggjort, dannede grundlag for Adejumoke Owolabis kandidatafhandling. Owolabi, en dataforsker ved University of Hull, UK, hentede rigtige billeder fra Flickr Faces HQ-datasæt og skabte falske ansigter ved hjælp af en billedgenerator. Owolabi analyserede derefter refleksionerne fra lyskilder i øjnene i billederne ved hjælp af to astronomiske målinger: CAS-systemet og Gini-indekset. CAS-systemet kvantificerer koncentrationen, asymmetrien og glatheden af et objekts lysfordeling. Denne teknik har gjort det muligt for astronomer, herunder Pimbblet, at karakterisere lyset fra ekstragalaktiske stjerner i årtier. Gini-indekset måler uligheden i lysfordelingen i billeder af galakser.

Ved at sammenligne refleksioner i en persons øjenæbler var Owolabi i stand til korrekt at forudsige, om billedet var falsk omkring 70 % af tiden. I sidste ende fandt forskerne ud af, at Gini-indekset var bedre end CAS-systemet til at forudsige, om et billede var blevet manipuleret.

Brant Robertson, en astrofysiker ved University of California, Santa Cruz, hilser forskningen velkommen. "Men hvis du kan beregne en værdi, der kvantificerer, hvor realistisk et deepfake-billede kan fremstå, kan du også træne AI-modellen til at producere endnu bedre deepfakes ved at optimere denne værdi," advarer han.

Zhiwu Huang, en AI-forsker ved University of Southampton, Storbritannien, siger, at hans egen forskning ikke har identificeret nogen inkonsekvente lysmønstre i øjnene af deepfake billeder. Men "mens den specifikke teknik med at bruge inkonsekvente refleksioner i øjeæblerne måske ikke er almindeligt anvendelige, kan sådanne teknikker være nyttige til at analysere subtile anomalier i belysning, skygger og refleksioner i forskellige dele af et billede," siger han. "At detektere uoverensstemmelser i lysets fysiske egenskaber kan supplere eksisterende metoder og forbedre den overordnede nøjagtighed af deepfake-detektion."

Suche

Suche

Mein Konto

Mein Konto