Los investigadores utilizan técnicas de la astronomía para crear imágenes generadas por computadora. Imágenes “deepfakes” reconocer, que a primera vista pueden parecer idénticas a fotografías reales.

Al analizar imágenes de rostros que normalmente se utilizan para estudiar galaxias distantes, los astrónomos pueden medir cómo los ojos de una persona reflejan la luz, lo que puede indicar signos de manipulación de imágenes.

"No es una panacea, ya que tenemos falsos positivos y falsos negativos", afirma Kevin Pimbblet, director del Centro de Ciencia de Datos, Inteligencia Artificial y Modelado de la Universidad de Hull, Reino Unido. Presentó la investigación en la Reunión Nacional de Astronomía de la Royal Astronomical Society el 15 de julio. "Pero esta investigación ofrece un método potencial, un importante paso adelante, para agregar potencialmente a las pruebas que pueden usarse para descubrir si una imagen es real o falsa".

Fotos expresadas

Los avances en inteligencia artificial (IA) hacen que sea cada vez más difícil diferenciar entre imágenes, vídeos y audio reales. los creados por algoritmos, reconocer. Los deepfakes reemplazan características de una persona o entorno con otras y pueden hacer que parezca como si las personas hubieran dicho o hecho cosas que no dijeron. Las autoridades advierten que esta tecnología se está militarizando y contribuyendo a la difusión de información errónea, por ejemplo durante las elecciones, se puede utilizar.

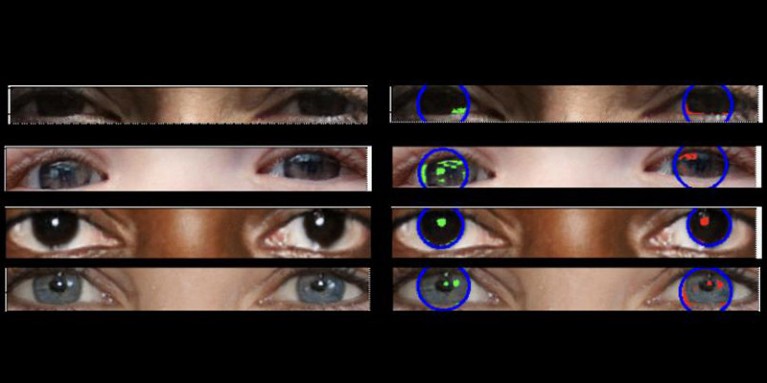

Las fotos reales deben tener una "física consistente", explica Pimbblet, "por lo que los reflejos que se ven en el globo ocular izquierdo deben ser muy similares, aunque no necesariamente idénticos, a los reflejos del globo ocular derecho". Las diferencias son sutiles, por lo que los investigadores recurrieron a técnicas desarrolladas para analizar la luz en imágenes astronómicas.

El trabajo, que aún no ha sido publicado, sirvió de base para la tesis de maestría de Adejumoke Owolabi. Owolabi, científico de datos de la Universidad de Hull, Reino Unido, obtuvo imágenes reales del Flickr se enfrenta al conjunto de datos HQ y creó caras falsas usando un generador de imágenes. Luego, Owolabi analizó los reflejos de las fuentes de luz en los ojos en las imágenes utilizando dos mediciones astronómicas: el sistema CAS y el índice de Gini. El sistema CAS cuantifica la concentración, la asimetría y la suavidad de la distribución de la luz de un objeto. Esta técnica ha permitido a los astrónomos, incluido Pimbblet, caracterizar la luz de estrellas extragalácticas durante décadas. El índice de Gini mide la desigualdad en la distribución de la luz en imágenes de galaxias.

Al comparar los reflejos en los globos oculares de una persona, Owolabi pudo predecir correctamente si la imagen era falsa aproximadamente el 70% de las veces. Al final, los investigadores descubrieron que el índice de Gini era mejor que el sistema CAS a la hora de predecir si una imagen había sido manipulada.

Brant Robertson, astrofísico de la Universidad de California en Santa Cruz, acoge con satisfacción la investigación. “Sin embargo, si se puede calcular un valor que cuantifique qué tan realista puede parecer una imagen deepfake, también se puede entrenar el modelo de IA para producir deepfakes aún mejores optimizando ese valor”, advierte.

Zhiwu Huang, investigador de inteligencia artificial de la Universidad de Southampton, Reino Unido, dice que su propia investigación no ha identificado ningún patrón de luz inconsistente en los ojos de imágenes ultrafalsas. Pero "si bien la técnica específica de utilizar reflejos inconsistentes en los globos oculares puede no ser ampliamente aplicable, tales técnicas podrían ser útiles para analizar anomalías sutiles en la iluminación, las sombras y los reflejos en diferentes partes de una imagen", dice. "La detección de inconsistencias en las propiedades físicas de la luz podría complementar los métodos existentes y mejorar la precisión general de la detección de deepfake".

Suche

Suche

Mein Konto

Mein Konto