Onderzoekers gebruiken technieken uit de astronomie om computergegenereerde beelden te creëren ‘Deepfake’-afbeeldingen te herkennen - die er op het eerste gezicht identiek uit kunnen zien als echte foto's.

Door afbeeldingen te analyseren van gezichten die doorgaans worden gebruikt om verre sterrenstelsels te bestuderen, kunnen astronomen meten hoe iemands ogen licht reflecteren, wat kan duiden op tekenen van beeldmanipulatie.

“Het is geen wondermiddel, want we hebben valse positieven en valse negatieven”, zegt Kevin Pimbblet, directeur van het Center for Data Science, Artificial Intelligence and Modeling aan de Universiteit van Hull, VK. Hij presenteerde het onderzoek op de National Astronomy Meeting van de Royal Astronomical Society op 15 juli. "Maar dit onderzoek biedt een potentiële methode, een belangrijke stap voorwaarts, om mogelijk toe te voegen aan de tests die kunnen worden gebruikt om erachter te komen of een afbeelding echt of nep is."

Uitgedrukte foto's

Door de vooruitgang op het gebied van kunstmatige intelligentie (AI) wordt het steeds moeilijker om het verschil te zien tussen echte afbeeldingen, video's en audio die gecreëerd zijn door algoritmen, herkennen. Deepfakes vervangen kenmerken van de ene persoon of omgeving door die van anderen en kunnen de indruk wekken dat individuen dingen hebben gezegd of gedaan die ze niet hebben gedaan. De autoriteiten waarschuwen dat deze technologie militariserend werkt en bijdraagt aan de verspreiding van desinformatie. bijvoorbeeld tijdens verkiezingen, kan worden gebruikt.

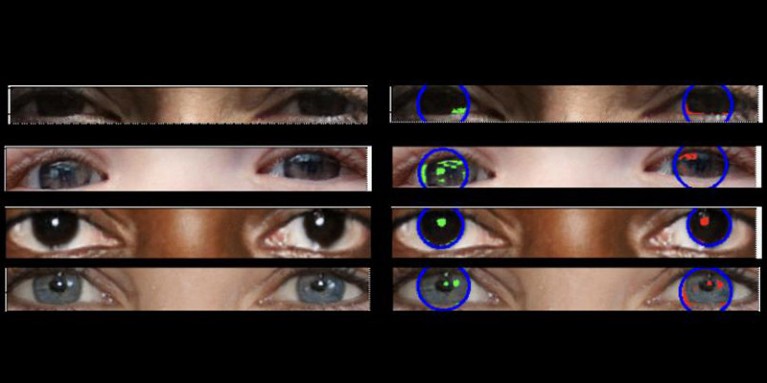

Echte foto's moeten een "consistente fysica" hebben, legt Pimbblet uit, "dus de reflecties die je in de linkeroogbol ziet, moeten zeer vergelijkbaar zijn met, hoewel niet noodzakelijkerwijs identiek, aan de reflecties in de rechteroogbol." De verschillen zijn subtiel, dus wendden de onderzoekers zich tot technieken die waren ontwikkeld voor het analyseren van licht in astronomische beelden.

Het nog niet gepubliceerde werk vormde de basis voor de masterscriptie van Adejumoke Owolabi. Owolabi, een datawetenschapper aan de Universiteit van Hull, VK, heeft echte beelden verzameld van de Flickr Faces HQ-gegevensset en creëerde nepgezichten met behulp van een beeldgenerator. Owolabi analyseerde vervolgens de reflecties van lichtbronnen in de ogen in de beelden met behulp van twee astronomische metingen: het CAS-systeem en de Gini-index. Het CAS-systeem kwantificeert de concentratie, asymmetrie en gelijkmatigheid van de lichtverdeling van een object. Dankzij deze techniek kunnen astronomen, waaronder Pimbblet, al tientallen jaren het licht van extragalactische sterren karakteriseren. De Gini-index meet de ongelijkheid van de lichtverdeling in afbeeldingen van sterrenstelsels.

Door de reflecties in de oogbollen van een persoon te vergelijken, kon Owolabi in ongeveer 70% van de gevallen correct voorspellen of het beeld nep was. Uiteindelijk ontdekten de onderzoekers dat de Gini-index beter was dan het CAS-systeem in het voorspellen of een afbeelding was gemanipuleerd.

Brant Robertson, astrofysicus aan de Universiteit van Californië, Santa Cruz, verwelkomt het onderzoek. “Als je echter een waarde kunt berekenen die kwantificeert hoe realistisch een deepfake-afbeelding kan lijken, kun je het AI-model ook trainen om nog betere deepfakes te produceren door die waarde te optimaliseren”, waarschuwt hij.

Zhiwu Huang, een AI-onderzoeker aan de Universiteit van Southampton, VK, zegt dat zijn eigen onderzoek geen inconsistente lichtpatronen heeft geïdentificeerd in de ogen van deepfake-beelden. Maar "hoewel de specifieke techniek van het gebruik van inconsistente reflecties in de oogbollen misschien niet breed toepasbaar is, kunnen dergelijke technieken nuttig zijn voor het analyseren van subtiele afwijkingen in belichting, schaduwen en reflecties in verschillende delen van een beeld", zegt hij. “Het detecteren van inconsistenties in de fysieke eigenschappen van licht zou een aanvulling kunnen zijn op bestaande methoden en de algehele nauwkeurigheid van deepfake-detectie kunnen verbeteren.”

Suche

Suche

Mein Konto

Mein Konto