Cercetătorii folosesc tehnici din astronomie pentru a crea produse generate de computer Imagini „deepfake”. a recunoaște - care la prima vedere poate părea identic cu fotografiile reale.

Analizând imaginile fețelor folosite de obicei pentru a studia galaxiile îndepărtate, astronomii pot măsura modul în care ochii unei persoane reflectă lumina, ceea ce poate indica semne de manipulare a imaginii.

„Nu este un panaceu, deoarece avem false pozitive și false negative”, spune Kevin Pimbblet, directorul Centrului pentru Știința Datelor, Inteligență Artificială și Modelare de la Universitatea Hull, Marea Britanie. El a prezentat cercetarea la Reuniunea Națională de Astronomie a Societății Regale de Astronomie, pe 15 iulie. „Dar această cercetare oferă o metodă potențială, un pas important înainte, care poate fi adăugat la testele care pot fi folosite pentru a afla dacă o imagine este reală sau falsă”.

Fotografii exprimate

Progresele în inteligența artificială (AI) fac din ce în ce mai dificil să se facă diferența dintre imaginile, videoclipurile și sunetul reale cele create de algoritmi, a recunoaște. Deepfake-urile înlocuiesc caracteristicile unei persoane sau ale unui mediu cu altele și pot face să pară ca și cum indivizii au spus sau au făcut lucruri pe care nu le-au făcut. Autoritățile avertizează că această tehnologie se militarizează și contribuie la răspândirea dezinformării, de exemplu în timpul alegerilor, poate fi folosit.

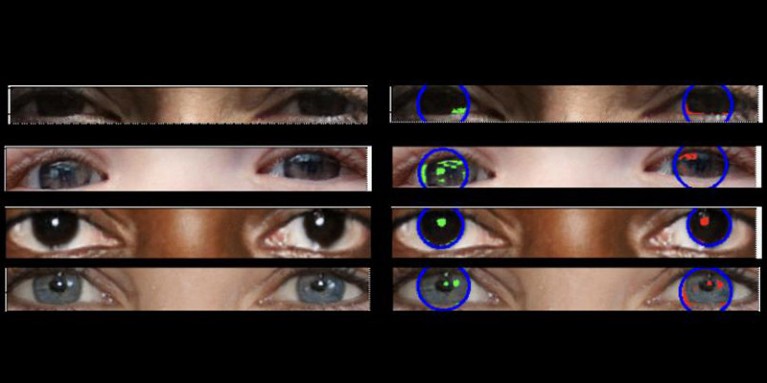

Fotografiile reale ar trebui să aibă o „fizică consistentă”, explică Pimbblet, „deci reflexiile pe care le vezi în globul ocular stâng ar trebui să fie foarte asemănătoare, deși nu neapărat identice, cu reflexiile din globul ocular drept”. Diferențele sunt subtile, așa că cercetătorii au apelat la tehnici dezvoltate pentru analiza luminii în imaginile astronomice.

Lucrarea, care nu a fost încă publicată, a stat la baza tezei de master a lui Adejumoke Owolabi. Owolabi, un cercetător de date la Universitatea din Hull, Marea Britanie, a obținut imagini reale de la Setul de date Flickr Faces HQ și a creat fețe false folosind un generator de imagini. Owolabi a analizat apoi reflexiile de la sursele de lumină în ochi în imagini folosind două măsurători astronomice: sistemul CAS și indicele Gini. Sistemul CAS cuantifică concentrația, asimetria și netezimea distribuției luminii unui obiect. Această tehnică a permis astronomilor, inclusiv lui Pimbblet, să caracterizeze lumina stelelor extragalactice timp de decenii. Indicele Gini măsoară inegalitatea distribuției luminii în imaginile galaxiilor.

Comparând reflexiile din globii oculari ai unei persoane, Owolabi a reușit să prezică corect dacă imaginea era falsă în aproximativ 70% din timp. În cele din urmă, cercetătorii au descoperit că indicele Gini a fost mai bun decât sistemul CAS în a prezice dacă o imagine a fost manipulată.

Brant Robertson, astrofizician la Universitatea din California, Santa Cruz, salută cercetarea. „Cu toate acestea, dacă puteți calcula o valoare care cuantifică cât de realistă poate apărea o imagine deepfake, puteți, de asemenea, antrena modelul AI pentru a produce deepfake-uri și mai bune prin optimizarea acestei valori”, avertizează el.

Zhiwu Huang, un cercetător AI la Universitatea din Southampton, Marea Britanie, spune că propria sa cercetare nu a identificat niciun model de lumină inconsecvent în ochii imaginilor deepfake. Dar „în timp ce tehnica specifică de utilizare a reflexiilor inconsistente în globii oculari poate să nu fie aplicabilă pe scară largă, astfel de tehnici ar putea fi utile pentru analizarea anomaliilor subtile ale luminii, umbrelor și reflexiilor în diferite părți ale unei imagini”, spune el. „Detectarea inconsecvențelor în proprietățile fizice ale luminii ar putea completa metodele existente și ar putea îmbunătăți acuratețea generală a detectării deepfake.”

Suche

Suche

Mein Konto

Mein Konto