Forskare använder tekniker från astronomi för att skapa datorgenererade "Deepfake"-bilder att känna igen - som vid första anblicken kan se identiska ut med riktiga bilder.

Genom att analysera bilder av ansikten som vanligtvis används för att studera avlägsna galaxer kan astronomer mäta hur en persons ögon reflekterar ljus, vilket kan indikera tecken på bildmanipulation.

"Det är inget universalmedel eftersom vi har falska positiva och falska negativa resultat", säger Kevin Pimbblet, chef för Center for Data Science, Artificial Intelligence and Modeling vid University of Hull, Storbritannien. Han presenterade forskningen vid Royal Astronomical Society's National Astronomy Meeting den 15 juli. "Men den här forskningen erbjuder en potentiell metod, ett viktigt steg framåt, för att potentiellt lägga till de tester som kan användas för att ta reda på om en bild är verklig eller falsk."

Uttryckta bilder

Framsteg inom artificiell intelligens (AI) gör det allt svårare att se skillnad på riktiga bilder, videor och ljud de som skapas av algoritmer, att känna igen. Deepfakes ersätter egenskaper hos en person eller miljö med andra och kan få det att se ut som om individer har sagt eller gjort saker som de inte gjorde. Myndigheter varnar för att denna teknik militariserar och bidrar till spridningen av desinformation, till exempel vid val, kan användas.

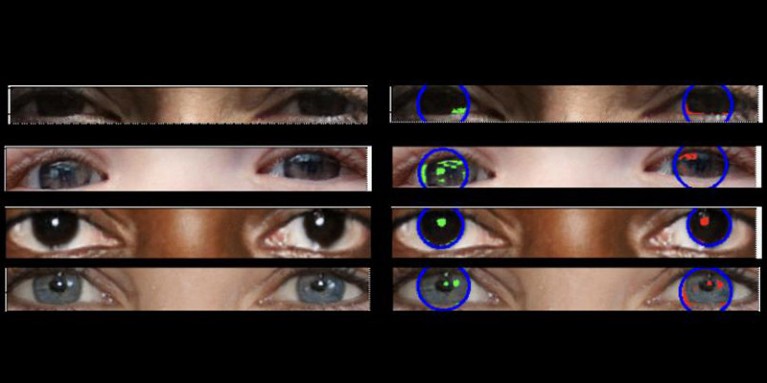

Riktiga foton ska ha "konsekvent fysik", förklarar Pimbblet, "så reflektionerna du ser i den vänstra ögongloben bör vara väldigt lika, även om de inte nödvändigtvis är identiska, med reflektionerna i den högra ögongloben." Skillnaderna är subtila, så forskarna vände sig till tekniker utvecklade för att analysera ljus i astronomiska bilder.

Verket, som ännu inte har publicerats, låg till grund för Adejumoke Owolabis magisteruppsats. Owolabi, en dataforskare vid University of Hull, Storbritannien, hämtade riktiga bilder från Flickr Faces HQ Dataset och skapade falska ansikten med hjälp av en bildgenerator. Owolabi analyserade sedan reflektionerna från ljuskällor i ögonen i bilderna med hjälp av två astronomiska mätningar: CAS-systemet och Gini-index. CAS-systemet kvantifierar koncentrationen, asymmetrin och jämnheten i ett objekts ljusfördelning. Denna teknik har gjort det möjligt för astronomer, inklusive Pimbblet, att karakterisera ljuset från extragalaktiska stjärnor i årtionden. Gini-indexet mäter ojämlikheten i ljusfördelningen i bilder av galaxer.

Genom att jämföra reflektionerna i en persons ögonglober kunde Owolabi korrekt förutsäga om bilden var falsk ungefär 70 % av gångerna. I slutändan fann forskarna att Gini-indexet var bättre än CAS-systemet på att förutsäga om en bild hade manipulerats.

Brant Robertson, en astrofysiker vid University of California, Santa Cruz, välkomnar forskningen. "Men om du kan beräkna ett värde som kvantifierar hur realistisk en deepfake-bild kan se ut, kan du också träna AI-modellen att producera ännu bättre deepfakes genom att optimera det värdet", varnar han.

Zhiwu Huang, en AI-forskare vid University of Southampton, Storbritannien, säger att hans egen forskning inte har identifierat några inkonsekventa ljusmönster i ögonen på djupfalska bilder. Men "även om den specifika tekniken att använda inkonsekventa reflektioner i ögongloberna kanske inte är allmänt tillämpbar, kan sådana tekniker vara användbara för att analysera subtila anomalier i ljus, skuggor och reflektioner i olika delar av en bild", säger han. "Att upptäcka inkonsekvenser i ljusets fysiska egenskaper kan komplettera befintliga metoder och förbättra den övergripande noggrannheten för deepfake-detektering."

Suche

Suche

Mein Konto

Mein Konto