Door AI gegenereerde beelden brengen de wetenschap in gevaar – zo willen onderzoekers ze herkennen

Onderzoekers strijden tegen door AI gegenereerde nepbeelden in wetenschappelijke publicaties. Er ontwikkelen zich nieuwe detectiemethoden.

Door AI gegenereerde beelden brengen de wetenschap in gevaar – zo willen onderzoekers ze herkennen

Wetenschappers die cijfers manipuleren en massaal neppapier produceren Verplichte uitgevers – problematische manuscripten zijn lange tijd hinderlijk geweest in de wetenschappelijke literatuur. Wetenschappelijke detectives werken onvermoeibaar, om dit wangedrag aan het licht te brengen en het wetenschappelijke record te corrigeren. Maar hun taak wordt steeds moeilijker nu er een nieuw, krachtig instrument voor fraudeurs is ontstaan: generatief kunstmatige intelligentie (AI).

“Generatieve AI ontwikkelt zich zeer snel”, zegt Jan Christoffel, Image Integrity Analyst bij FEBS Press in Heidelberg, Duitsland. “Mensen die in mijn omgeving werken – imago-integriteit en publicatiebeleid – maken zich steeds meer zorgen over de mogelijkheden die dit biedt.”

Het gemak waarmee teksten voor generatieve AI-tools, beelden en gegevens doen de vrees rijzen voor een steeds onbetrouwbaardere wetenschappelijke literatuur, overspoeld met valse cijfers, manuscripten en conclusies die voor mensen moeilijk te ontdekken zijn. Er ontstaat nu al een wapenwedloop waar integriteitsspecialisten, uitgeverijen en technologiebedrijven hard aan werken Ontwikkel AI-tools, waarmee u snel misleidende, door AI gegenereerde elementen in specialistische artikelen kunt identificeren.

“Het is een beangstigende ontwikkeling”, zegt Christopher. “Maar er zijn ook slimme mensen en er worden goede structurele veranderingen voorgesteld.”

Experts op het gebied van onderzoeksintegriteit melden dat, hoewel AI-gegenereerde tekst onder bepaalde omstandigheden al door veel tijdschriften is toegestaan, het gebruik van dergelijke tools om afbeeldingen of andere gegevens te creëren als minder acceptabel kan worden beschouwd. “In de nabije toekomst zullen we misschien wel akkoord gaan met door AI gegenereerde tekst”, zegt Elisabeth Bik, beeldforensisch specialist en adviseur in San Francisco, Californië. “Maar ik trek de grens als het gaat om het genereren van data.”

Bik, Christopher en anderen suggereren dat gegevens, inclusief afbeeldingen, gemaakt met generatieve AI al op grote schaal worden gebruikt in de literatuur, en dat verplichte uitgevers AI-tools gebruiken om manuscripten in volume te produceren (zie ‘Quiz: kun je AI-vervalsingen spotten?’).

Het identificeren van door AI geproduceerde beelden vormt een enorme uitdaging: ze zijn vaak bijna onmogelijk met het blote oog van echte beelden te onderscheiden. “We hebben het gevoel dat we elke dag door AI gegenereerde beelden tegenkomen”, zegt Christopher. “Maar tenzij je het kunt bewijzen, kun je eigenlijk heel weinig doen.”

Er zijn enkele duidelijke voorbeelden van het gebruik van generatieve AI in wetenschappelijke beelden, zoals de nu beruchte afbeelding van een rat met absurd grote geslachtsdelen en onzinnige labels, gemaakt met de Midjourney-afbeeldingstool. De graphic, die in februari door een vakblad werd gepubliceerd, veroorzaakte een storm op sociale media en was dat ook een paar dagen later ingetrokken.

De meeste gevallen zijn echter niet zo duidelijk. Figuren die zijn gemaakt met Adobe Photoshop of soortgelijke tools vóór de komst van generatieve AI - vooral in de moleculaire en cellulaire biologie - bevatten vaak opvallende kenmerken die door detectives kunnen worden herkend, zoals identieke achtergronden of het ongebruikelijke ontbreken van strepen of vlekken. Door AI gegenereerde karakters vertonen dergelijke kenmerken vaak niet. "Ik zie veel papieren die me doen denken dat deze Western blots er niet echt uitzien, maar er is geen smoking gun", zegt Bik. "Het enige wat je kunt zeggen is dat ze er gewoon vreemd uitzien, en dat is natuurlijk niet genoeg bewijs om contact op te nemen met de redacteur."

Er zijn echter tekenen dat door AI gegenereerde karakters in gepubliceerde manuscripten voorkomen. Het aantal teksten dat is geschreven met tools als ChatGPT neemt toe in artikelen, wat blijkt uit typische chatbotzinnen die auteurs vergeten te verwijderen en onderscheidende woorden die AI-modellen vaak gebruiken. “We moeten er dus van uitgaan dat dit ook voor data en beelden gebeurt”, zegt Bik.

Een andere aanwijzing dat fraudeurs geavanceerde beeldvormingshulpmiddelen gebruiken, is dat de meeste problemen die onderzoekers momenteel tegenkomen, voorkomen in werken die enkele jaren oud zijn. “De laatste jaren zien we steeds minder problemen met beelden”, zegt Bik. “Ik denk dat de meeste mensen die betrapt werden op het manipuleren van afbeeldingen, schonere afbeeldingen begonnen te maken.”

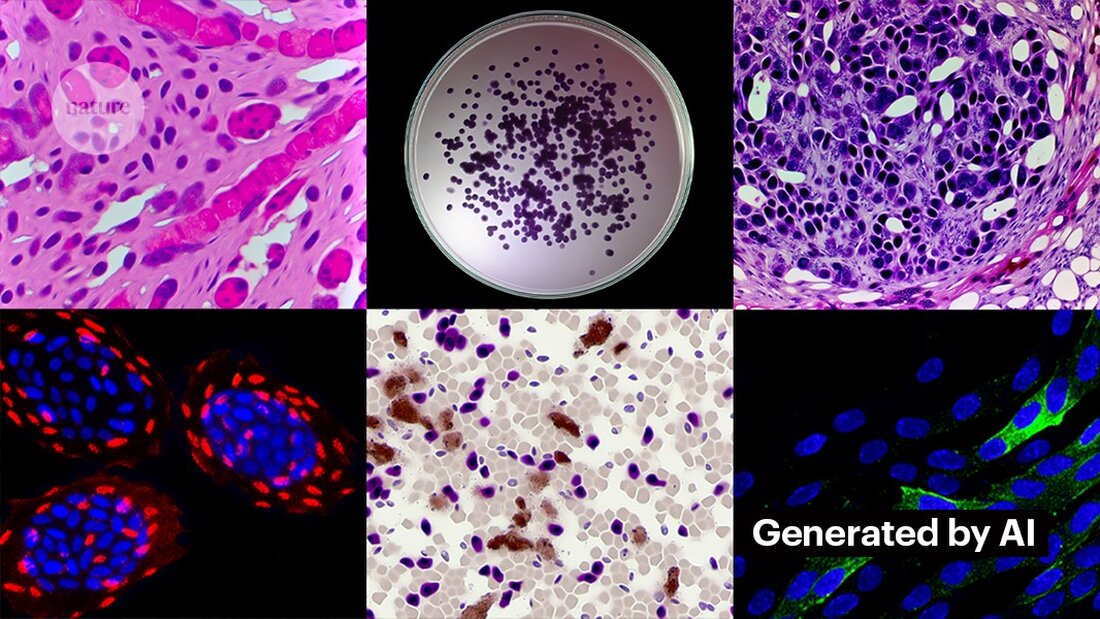

Het creëren van zuivere afbeeldingen met generatieve AI is niet moeilijk. Kevin Patrick, een wetenschappelijke beelddetective die op sociale media bekend staat als Cheshire, heeft laten zien hoe gemakkelijk het kan zijn en publiceerde zijn bevindingen op X. Met behulp van Photoshop's AI-tool Generative Fill creëerde Patrick realistische afbeeldingen - die in wetenschappelijke artikelen zouden kunnen verschijnen - van tumoren, celculturen, Western blots en meer. Het maken van de meeste afbeeldingen duurde minder dan een minuut (zie ‘Het genereren van valse wetenschap’).

“Als ik dat kan, zullen degenen die betaald worden om valse gegevens te creëren dat zeker ook doen”, zegt Patrick. “Er zijn waarschijnlijk nog heel veel andere gegevens die met dit soort tools kunnen worden gegenereerd.”

Sommige uitgevers melden dat ze in gepubliceerde onderzoeken bewijs hebben gevonden voor door AI gegenereerde inhoud. Dit geldt ook voor PLoS, dat via intern onderzoek is gewaarschuwd voor verdachte inhoud en bewijs heeft gevonden van door AI gegenereerde tekst en gegevens in artikelen en inzendingen, zegt Renée Hoch, redacteur van het publicatie-ethiekteam van PLoS in San Francisco, Californië. (Hoch merkt op dat het gebruik van AI niet verboden is in PLoS-tijdschriften en dat het AI-beleid gebaseerd is op auteursverantwoordelijkheid en transparante onthullingen.)

Andere tools kunnen ook kansen bieden voor mensen die nepinhoud willen creëren. Vorige maand publiceerden onderzoekers een 1 generatief AI-model om microscoopbeelden met hoge resolutie te maken – en sommige integriteitsspecialisten uitten hun zorgen over dit werk. “Deze technologie kan gemakkelijk worden gebruikt door mensen met slechte bedoelingen om snel honderden of duizenden nepafbeeldingen te maken”, zegt Bik.

Yoav Shechtman van het Technion-Israel Institute of Technology in Haifa, de maker van de tool, zegt dat de tool nuttig is voor het creëren van trainingsgegevens voor modellen, omdat microscoopbeelden met hoge resolutie moeilijk te verkrijgen zijn. Maar hij voegt eraan toe dat het niet nuttig is om vervalsingen te genereren, omdat gebruikers weinig controle hebben over de resultaten. Bestaande beeldbewerkingssoftware zoals Photoshop is handiger voor het manipuleren van figuren, suggereert hij.

Hoewel menselijke ogen dat misschien niet kunnen Herken door AI gegenereerde afbeeldingen, zou AI dit mogelijk kunnen doen (zie ‘AI-beelden zijn moeilijk te herkennen’).

De ontwikkelaars van tools als Imagetwin en Proofig, die AI gebruiken om integriteitsproblemen in wetenschappelijke beelden op te sporen, breiden hun software uit om beelden te filteren die zijn gemaakt door generatieve AI. Omdat dergelijke afbeeldingen zo moeilijk te herkennen zijn, creëren beide bedrijven hun eigen databases met generatieve AI-afbeeldingen om hun algoritmen te trainen.

Proofig heeft al een functie in zijn tool uitgebracht voor het herkennen van door AI gegenereerde microscoopbeelden. Mede-oprichter Dror Kolodkin-Gal in Rehovot, Israël, zegt dat bij het testen met duizenden door AI gegenereerde en echte afbeeldingen uit artikelen het algoritme 98% van de tijd AI-afbeeldingen correct identificeerde en een fout-positief percentage van 0,02% had. Dror voegt eraan toe dat het team nu probeert te begrijpen wat hun algoritme precies detecteert.

“Ik heb hoge verwachtingen van deze tools”, zegt Christopher. Ze merkt echter op dat hun resultaten altijd moeten worden beoordeeld door experts die de door hen aangegeven problemen kunnen verifiëren. Christopher heeft nog geen enkel bewijs gezien dat AI-beeldherkenningssoftware betrouwbaar is (de interne evaluatie van Proofig is nog niet gepubliceerd). Deze tools zijn “beperkt, maar zeker erg nuttig om ons in staat te stellen onze inspanningen voor het beoordelen van inzendingen op te schalen”, voegt ze eraan toe.

Veel uitgevers en onderzoeksinstellingen maken er al gebruik van Bewijs En Afbeeldingtweeling. Science-tijdschriften gebruiken bijvoorbeeld Proofig om integriteitsproblemen in afbeeldingen te controleren. Volgens Meagan Phelan, communicatiedirecteur van Science in Washington DC, heeft de tool nog geen door AI gegenereerde afbeeldingen ontdekt.

Springer Nature, de uitgever van Nature, ontwikkelt zijn eigen tekst- en beelddetectietools, genaamd Geppetto en SnapShot, die onregelmatigheden signaleren die vervolgens door mensen worden geëvalueerd. (Het Nature-nieuwsteam is redactioneel onafhankelijk van de uitgever.)

Uitgeversgroepen ondernemen ook stappen om te reageren op door AI gegenereerde afbeeldingen. Een woordvoerder van de International Association of Scientific, Technical and Medical (STM) Publishers in Oxford, VK, zei dat zij de kwestie ‘zeer serieus’ nemen en reageren op initiatieven zoals United2Act en de STM Integrity Hub, die actuele problemen met verplichte publicaties en andere kwesties op het gebied van wetenschappelijke integriteit aanpakt.

Christopher, die leiding geeft aan een STM-werkgroep die zich bezighoudt met het wijzigen en dupliceren van afbeeldingen, zegt dat er een groeiend besef is dat het nodig zal zijn manieren te ontwikkelen om ruwe gegevens te verifiëren, bijvoorbeeld door afbeeldingen die met microscopen zijn gemaakt te labelen met onzichtbare watermerken die lijken op de gebruikte afbeeldingen. Watermerken in door AI gegenereerde teksten – dat zou de juiste manier kunnen zijn. Dit vereist nieuwe technologieën en nieuwe normen voor fabrikanten van apparaten, voegt ze eraan toe.

Patrick en anderen maken zich zorgen dat uitgevers niet snel genoeg handelen om de dreiging het hoofd te bieden. “We vrezen dat dit de zoveelste generatie problemen in de literatuur zal zijn die pas wordt aangepakt als het te laat is”, zegt hij.

Toch zijn sommigen optimistisch dat de door AI gegenereerde inhoud die vandaag de dag in artikelen verschijnt, in de toekomst ontdekt zal worden.

“Ik heb er alle vertrouwen in dat de technologie zodanig zal verbeteren dat ze de data herkent die vandaag de dag worden gecreëerd – omdat dit op een gegeven moment als relatief grof zal worden beschouwd”, zegt Patrick. "Fraudeurs zouden 's nachts niet goed moeten slapen. Ze zouden het huidige proces voor de gek kunnen houden, maar ik denk niet dat ze het proces voor altijd voor de gek kunnen houden."

-

Saguy, A. et al. Kleine meth. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto