Diviziunea de calcul AI: Oamenii de știință nu au acces la cipuri puternice pentru cercetarea lor

Academicienii din întreaga lume se luptă cu o putere de calcul insuficientă pentru cercetarea AI. Sondajul arată diferențe mari în accesul la GPU.

Diviziunea de calcul AI: Oamenii de știință nu au acces la cipuri puternice pentru cercetarea lor

Mulți oameni de știință din universități sunt frustrați de puterea limitată de calcul disponibilă pentru cercetarea lor în domeniul inteligenţă artificială (AI) este disponibil, după cum arată un sondaj al cadrelor universitare din zeci de instituții din întreaga lume.

Rezultatele 1, publicat pe 30 octombrie pe serverul de preprint arXiv, sugerează că academicienii nu au acces la cele mai avansate sisteme de calcul. Acest lucru vă poate afecta capacitatea de a modele de limbaj mari (LLM) să dezvolte și să desfășoare alte proiecte de cercetare IA.

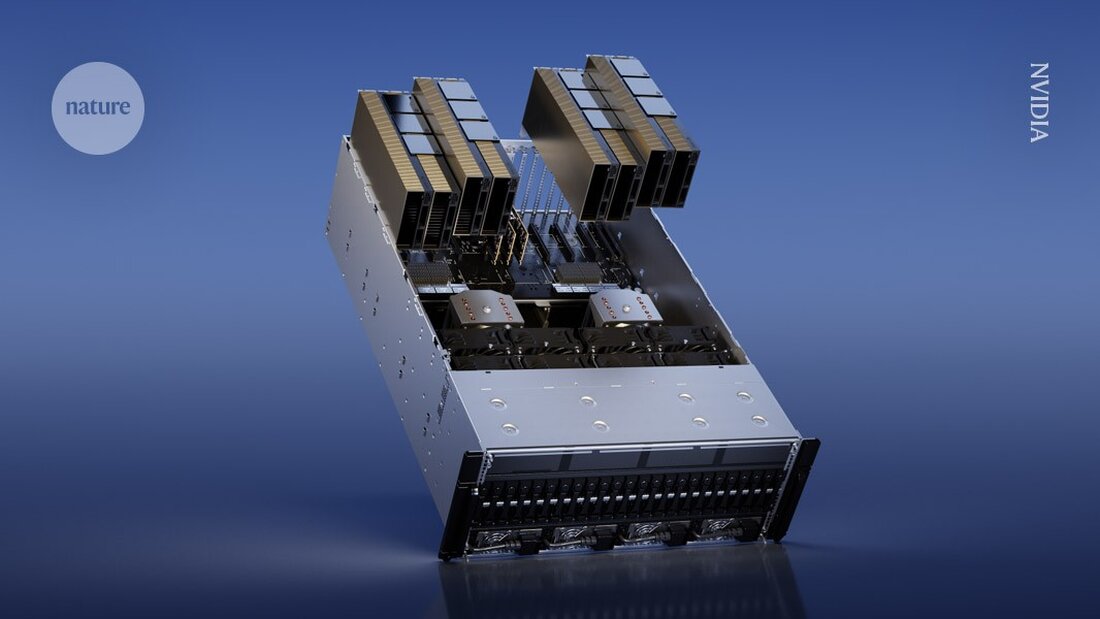

În special, cercetătorii academicieni nu au uneori resursele necesare pentru a fi puternici Procesoare grafice (GPU) de cumpărat – cipuri de computer utilizate în mod obișnuit pentru a antrena modele AI care pot costa câteva mii de dolari. În schimb, cercetătorii de la marile companii de tehnologie au bugete mai mari și pot cheltui mai mult pe GPU-uri. „Fiecare GPU adaugă mai multă putere”, spune coautorul studiului Apoorv Khandelwal, un informatician la Universitatea Brown din Providence, Rhode Island. „În timp ce acești giganți din industrie pot avea mii de GPU-uri, academicienii pot avea doar câteva.”

„Decalajul dintre modelele academice și cele industriale este mare, dar ar putea fi mult mai mic”, spune Stella Biderman, director executiv al EleutherAI, un institut nonprofit de cercetare AI din Washington DC. Cercetarea acestei inegalități este „foarte importantă”, adaugă ea.

Timpi de așteptare lenți

Pentru a evalua resursele de calcul disponibile pentru cadrele universitare, Khandelwal și colegii săi au chestionat 50 de oameni de știință din 35 de instituții. Dintre cei chestionați, 66% și-au evaluat satisfacția față de puterea lor de calcul la 3 sau mai puțin pe o scară de 5. „Nu sunt mulțumiți deloc”, spune Khandelwal.

Universitățile au reglementări diferite pentru accesul la GPU. Unele ar putea avea un cluster central de calcul partajat între departamente și studenți, unde cercetătorii pot solicita timp GPU. Alte instituții ar putea achiziționa mașini care pot fi utilizate direct de membrii laboratorului.

Unii oameni de știință au raportat că a trebuit să aștepte zile pentru a obține acces la GPU-uri, observând că timpii de așteptare au fost deosebit de mari în jurul termenelor limită ale proiectelor (consultați „Gâtul de strângere al resurselor de calcul”). Rezultatele evidențiază, de asemenea, inegalitățile globale în ceea ce privește accesul. De exemplu, un respondent a menționat dificultatea de a găsi GPU-uri în Orientul Mijlociu. Doar 10% dintre respondenți au declarat că au acces la GPU-urile NVIDIA H100, pentru a avea cipuri puternice concepute pentru cercetarea AI.

Această barieră face ca procesul de pre-formare – introducerea unor seturi mari de date în LLM – să fie deosebit de dificil. „Este atât de costisitor încât majoritatea cadrelor universitare nici măcar nu iau în considerare să facă știință în pre-formare”, spune Khandelwal. El și colegii săi cred că cadrele universitare oferă o perspectivă unică în cercetarea AI și că lipsa accesului la puterea de calcul ar putea limita domeniul de cercetare.

„Este foarte important să avem un mediu de cercetare academică sănătos, competitiv, pentru creșterea pe termen lung și dezvoltarea tehnologică pe termen lung”, spune co-autorul Ellie Pavlick, care studiază informatica și lingvistica la Universitatea Brown. „Când ai cercetări în industrie, există presiuni comerciale clare care uneori te tentează să exploatezi mai repede și să explorezi mai puțin.”

Metode eficiente

Cercetătorii au examinat, de asemenea, modul în care cadrele universitare ar putea folosi mai bine resursele de calcul mai puțin puternice. Ei au calculat cât timp ar fi necesar pentru a pregăti mai multe LLM-uri folosind hardware cu resurse reduse – între 1 și 8 GPU. În ciuda acestor resurse limitate, cercetătorii au reușit să antreneze cu succes multe dintre modele, deși a durat mai mult și le-a cerut să folosească metode mai eficiente.

„De fapt, putem folosi GPU-urile pe care le avem pentru mai mult timp și astfel putem atenua unele dintre diferențele dintre ceea ce are industrie”, spune Khandelwal.

„Este incitant să vezi că poți antrena un model mai mare decât și-ar imagina mulți oameni, chiar și cu resurse de calcul limitate”, spune Ji-Ung Lee, care studiază modele neuroexplicite la Universitatea Saarland din Saarbrücken, Germania. El adaugă că lucrările viitoare ar putea analiza experiențele cercetătorilor industriali de la companiile mici care, de asemenea, se luptă cu accesul la resurse de calcul. „Nu este ca și cum oricine are acces la o putere de calcul nelimitată chiar o primește”, spune el.

-

Khandelwal, A. şi colab. Pretipărire la arXiv https://doi.org/10.48550/arXiv.2410.23261 (2024).

Suche

Suche

Mein Konto

Mein Konto