Forscher greifen auf Techniken aus der Astronomie zurück, um computererzeugte „Deepfake“-Bilder zu erkennen – die auf den ersten Blick identisch mit echten Fotos aussehen können.

Indem sie Bilder von Gesichtern analysieren, die normalerweise zur Untersuchung entfernter Galaxien verwendet werden, können Astronomen messen, wie die Augen einer Person Licht reflektieren, was auf Anzeichen von Bildmanipulation hinweisen kann.

„Es ist kein Allheilmittel, da wir falsch-positive und falsch-negative Ergebnisse haben“, sagt Kevin Pimbblet, Direktor des Zentrums für Datenwissenschaft, Künstliche Intelligenz und Modellierung an der University of Hull, UK. Er präsentierte die Forschung auf der National Astronomy Meeting der Royal Astronomical Society am 15. Juli. „Aber diese Forschung bietet eine potenzielle Methode, einen wichtigen Schritt nach vorn, um möglicherweise zu den Tests hinzuzufügen, die angewendet werden können, um herauszufinden, ob ein Bild echt oder gefälscht ist.“

Geäußerte Fotos

Fortschritte in der künstlichen Intelligenz (KI) machen es zunehmend schwierig, den Unterschied zwischen echten Bildern, Videos und Audio und diesen, die von Algorithmen erstellt wurden, zu erkennen. Deepfakes ersetzen die Merkmale einer Person oder Umgebung durch andere und können es so aussehen lassen, als hätten Individuen Dinge gesagt oder getan, die sie nicht getan haben. Behörden warnen davor, dass diese Technologie militarisiert und zur Verbreitung von Fehlinformationen, zum Beispiel während Wahlen, verwendet werden kann.

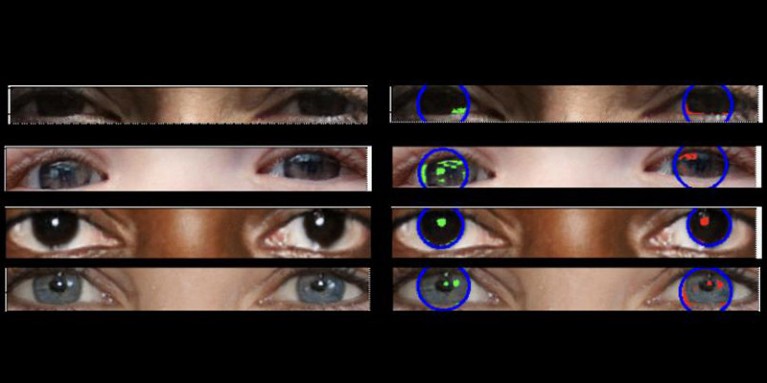

Echte Fotos sollten eine „konsistente Physik“ haben, erklärt Pimbblet, „so dass die Reflexionen, die Sie im linken Augapfel sehen, sehr ähnlich, wenn auch nicht unbedingt identisch, zu den Reflexionen im rechten Augapfel sein sollten“. Die Unterschiede sind subtil, daher griffen die Forscher auf Techniken zurück, die zur Analyse von Licht in astronomischen Bildern entwickelt wurden.

Die Arbeit, die noch nicht veröffentlicht wurde, bildete die Grundlage für die Masterarbeit von Adejumoke Owolabi. Owolabi, ein Data Scientist an der University of Hull, UK, bezog echte Bilder aus dem Flickr-Faces-HQ Dataset und erstellte gefälschte Gesichter mit einem Bildgenerator. Anschließend analysierte Owolabi die Reflexionen von Lichtquellen in den Augen in den Bildern unter Verwendung von zwei astronomischen Messungen: dem CAS-System und dem Gini-Index. Das CAS-System quantifiziert die Konzentration, Asymmetrie und Glattheit der Lichtverteilung eines Objekts. Diese Technik ermöglicht es Astronomen seit Jahrzehnten, darunter auch Pimbblet, das Licht extragalaktischer Sterne zu charakterisieren. Der Gini-Index misst die Ungleichheit der Lichtverteilung in Bildern von Galaxien.

Durch den Vergleich der Reflexionen in den Augäpfeln einer Person konnte Owolabi etwa 70% der Zeit korrekt vorhersagen, ob das Bild gefälscht war. Letztendlich stellten die Forscher fest, dass der Gini-Index besser als das CAS-System geeignet war, um vorherzusagen, ob ein Bild manipuliert wurde.

Brant Robertson, Astrophysiker an der University of California, Santa Cruz, begrüßt die Forschung. „Jedoch, wenn man einen Wert berechnen kann, der quantifiziert, wie realistisch ein Deepfake-Bild erscheinen mag, kann man das KI-Modell auch trainieren, noch bessere Deepfakes zu erzeugen, indem man diesen Wert optimiert“, warnt er.

Zhiwu Huang, KI-Forscher an der University of Southampton, UK, sagt, dass seine eigene Forschung keine inkonsistenten Lichtmuster in den Augen von Deepfake-Bildern identifiziert hat. Aber „während die spezifische Technik, inkonsistente Reflexionen in den Augäpfeln zu verwenden, möglicherweise nicht weit verbreitet anwendbar ist, könnten solche Techniken hilfreich sein, um subtile Anomalien in Beleuchtung, Schatten und Reflexionen in verschiedenen Teilen eines Bildes zu analysieren“, sagt er. „Das Erkennen von Inkonsistenzen in den physikalischen Eigenschaften von Licht könnte bestehende Methoden ergänzen und die Gesamtgenauigkeit der Deepfake-Erkennung verbessern.“